Spotkałem się z opinią, że Google nie indeksuje tekstów generowanych AI. Postanowiłem wykazać, że jeśli inne progowe warunki techniczne i jakościowe są spełnione, teksty stworzone przez sztuczną inteligencję mogą być indeksowane w ciągu paru godzin. Poniżej opisuję szczegóły tego prostego eksperymentu.

Najpierw opowiem skąd w ogóle pomysł na ten eksperyment. W dalszej części opisuję przebieg testu i wnioski.

Content

Geneza testu

Jeden z użytkowników grupy dyskusyjnej o SEO na Facebooku wrzucił post z pytaniem, dlaczego treści na jego stronie się nie indeksują. Wiele osób odpowiadało sugerując błędy techniczne na stronie i powołując się na różne okoliczności, które w indeksacji mogły szkodzić.

Jednym z najbardziej oczywistych rozwiązań zagadki był fakt, że domena jest stosunkowo świeża, ma mało treści i przede wszystkim nie jest podlinkowana. W efekcie Google nie miało powodu, aby stroną się specjalnie interesować i poświęcać jej uwagę – ustawić jej URL wysoko w kolejce crawlowania i poświęcać zasoby na indeksowanie.

Pozwolę sobie zacytować komentarz jednego z kolegów, który moim zdaniem sensownie wskazał rozwiązanie:

imo problem jest taki sam jak u większości mniejszych biznesów z takimi problemami. Jeśli nie ma typowo technicznych blokad (co pewnie by tu było w mig wyłapane na grupie), to Google dostaje za mało sygnałów, że ma coś z tą domeną robić względem konkurencji. Te sygnały to np. linki z innych domen (regularnie odwiedzanych przez boty), to przyrost site: w serwisie, to nawet mapa witryny, to zmiany na stronie i zgłoszenia ich do indeksowania przez GSC, aby (oczywiście kolokwializując) pokazać, że „mi zależy”. (…) Podciąganie indekserami, aby tylko zaspokoić tabelkę w Excelu, to wydmuszka. Jeśli algorytm pomija stronę do indeksacji (przy założeniu że ją odwiedza na bazie logów), to ma powód. I wciąganie na siłę do indeksu go nie rozwiązuje, a tylko łata. Tak jak to opisałem na początku, brak indeksacji to skutek, a nie przyczyna.

Grzegorz Strzelec, PapaSEO.com

Inny kolega zapytał, czy teksty były robione przez AI, a autor wątku chyba na to czekał, bo upatrywał w tym jedną z potencjalnych, kluczowych przyczyn. Wręcz zdziwił się, że nikt inny tej kwestii nie poruszył.

Kolega, który wspomniał o tekstach AI po chwili sensownie dodał, że „Jeżeli domena posiada już pewną reputację to takie wpisy lepiej się indeksują, natomiast przy świeżych domenach różnie to bywa”.

Postanowiłem zatem rozstrzygnąć, czy sam fakt, że artykuły były pisane przy wykorzystaniu AI (tudzież lepiej byłoby użyć sformułowania LLM) może być tu decydujący. Moim zdaniem nie miało to znaczenia. Gdyby na tej świeżej, niedogrzanej domenie opublikować słabe treści pisane przez człowieka, czy być może nawet całkiem niezłe artykuły pisane przez specjalistę, to również miałyby problem z indeksacją.

Nie będę linkował tutaj tego wpisu ani przywoływał domeny, bo nie chodzi o to żeby kogoś stygmatyzować czy żeby się spierać. Po prostu zainspirował mnie ten wątek do wykazania, że jest jak jest – teksty tworzone przy pomocy sztucznej inteligencji, w tym po prostu samego ChatGPT, mogą bez problemu wchodzić w indeks.

Edit: na prośbę kolegi, którego wpis i komentarz mnie zainspirował do tego prostego case study chciałbym podkreślić, że ten test nie jest po to, aby podejmować polemikę z nim. W późniejszej rozmowie dodał, że nawet nigdzie nie napisał, że te treści, o których indeksacji (w sumie to jej braku) mowa były robione przez AI. Niemniej zasugerował jasno, że na tym wątku należało się skupić przy diagnozie problemu – i właśnie to stało się genezą tego testu.

Disclaimer: Bardzo proszę o zwracanie uwagi na kwantyfikatory, których używam. Teksty AI mogą bez problemu wchodzić w indeks. To nie jest równoznaczne ze stwierdzeniem, że każdy tekst AI zostanie zindeksowany. Zależy to od szeregu czynników. Sebastian Heymann używa czasem pojęcia MVI (ang. Minimum Value to Index) i wydaje mi się to dość użyteczna koncepcja do interpretowania takich przypadków. Na blogu Linkhouse możecie przeczytać więcej na ten temat: https://linkhouse.pl/artykul/minimum-value-to-index-minimalna-wartosc-do-zaindeksowania-w-wyszukiwarce/

Niniejszy test wykazuje, że „stworzenie tekstu przez AI” nie jest po prostu w żaden sposób czynnikiem rozstrzygającym.

Przebieg testu indeksacji artykułów pisanych przez AI

Ok, przyjrzyjmy się przebiegowi testu. Składa się on z kilku prostych etapów:

- Przygotowanie treści,

- Publikacja i zgłoszenie URL,

- Obserwacja i wnioski.

Etap I – przygotowanie treści

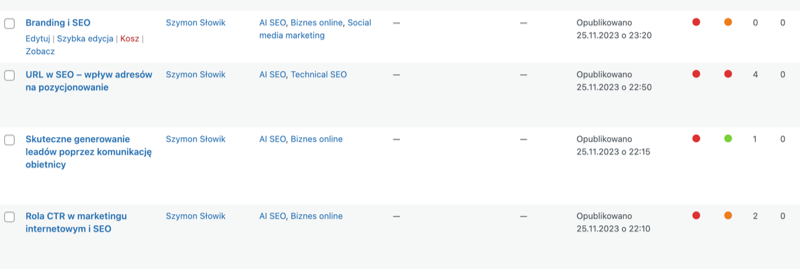

Postanowiłem stworzyć równolegle kilka artykułów na różne tematy, aby wykluczyć potem interpretacje, że dany tekst wszedł, ale to raczej wyjątek potwierdzający regułę. Ostatecznie przygotowałem 4 teksty różnymi metodami (chociaż wszystkie koniec końców sprowadzają się do wykorzystania modeli GPT).

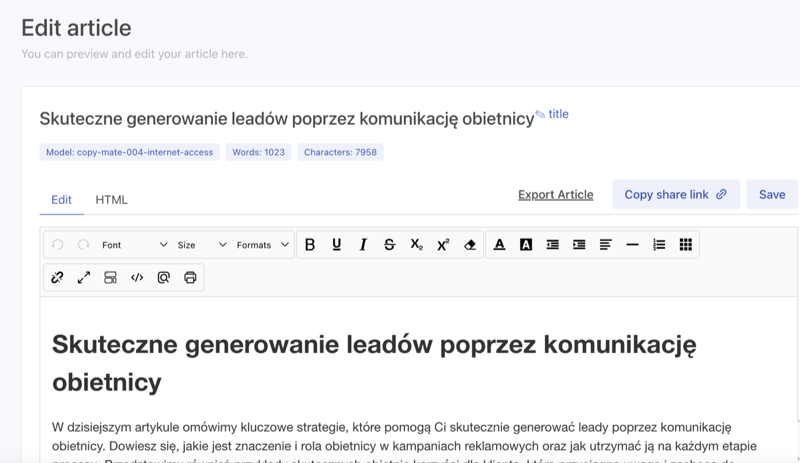

Tekst 1: Skuteczne generowanie leadów poprzez komunikację obietnicy stworzony przy pomocy Copymate z podanym tekstem źródłowym (sprawdź – na start dostajesz pakiet darmowych tokenów na testy)

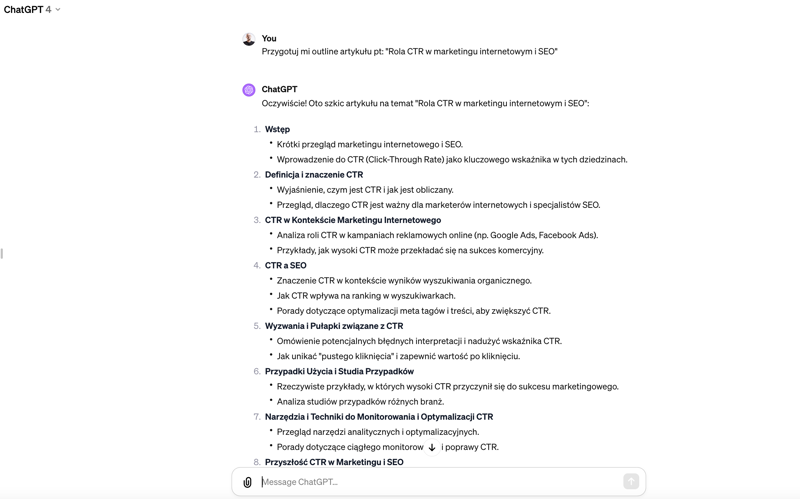

Tekst 2: Rola CTR w marketingu internetowym i SEO przygotowany bezpośrednio w ChatGPT bez żadnych dodatkowych analiz, wsadów, założeń. Poprosiłem ChatGPT o przygotowanie listy zagadnień (śródtytułów), a następnie przygotowanie treści do poszczególnych akapitów.

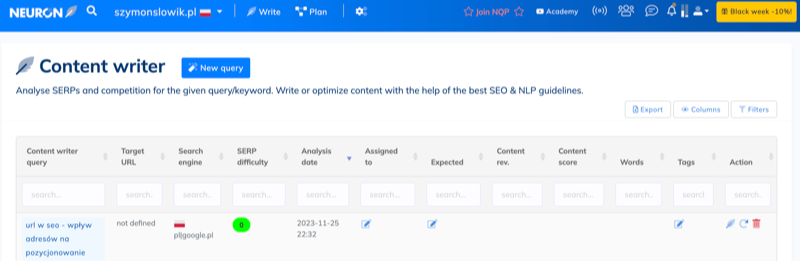

Tekst 3: URL w SEO – wpływ adresów na pozycjonowanie – stworzony z wykorzystaniem analizy SERP w Senuto (sprawdź ich nowego asystenta AI) oraz w NeuronWriter (również polecam testy – narzędzie posiada też własny moduł AI do generowania outline i treści akapitów).

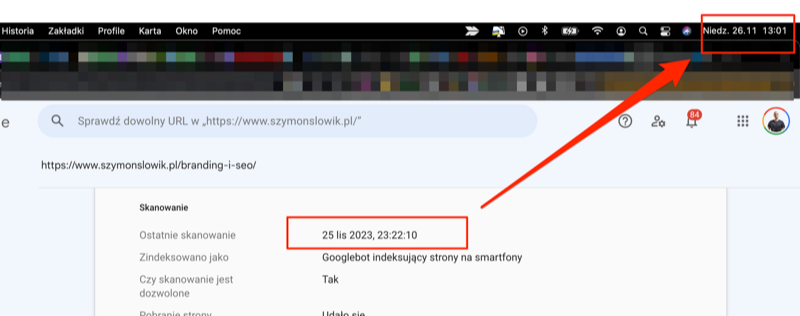

Data analizy na screenie powyżej pokazuje, że całość testu przebiegała w godzinach wieczornych 25.11.

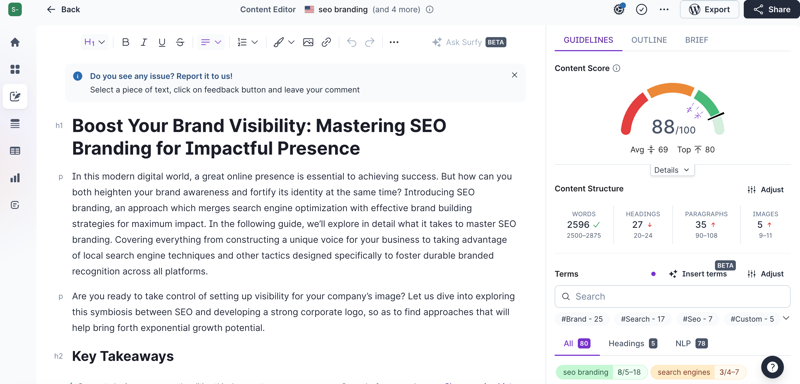

Tekst 4: Branding i SEO – artykuł w całości wygenerowany w Surfer (także zachęcam do testowania – macie tokeny, które generują całe artykuły) i przetłumaczony (przyznam, że miejscami dość niezdarnie, ale to nawet lepiej) w ChatGPT.

Etap 2 – publikacja i zgłoszenie

Między 22:10 a 23:20 opublikowałem wszystkie wpisy:

Następnie każdy z nich zgłosiłem w Google Search Console za pomocą inspektora URL.

Ponadto wrzuciłem tweeta z odnośnikiem do każdego URL:

Wrzucam dla testu 4 teksty robione za pomocą AI na blogu z jakimś autorytetem – sprawdźmy, czy wejdzie w indeks (czysty ChatGPT; ChatGPT z outline i frazy z @SenutoTool + frazy z @neuronwriter1; copymate; @surfer_seo AI + tłumaczenie w gpt). https://t.co/SEnHFsrSJO

— Szymon Słowik (@szymonslowik) 25 listopada 2023

No i w zasadzie tyle. Nie używałem żadnych indekserów ani nie linkowałem wpisów z innych źródeł. Pozostało tylko czekać.

Etap 3 – obserwacja i wnioski

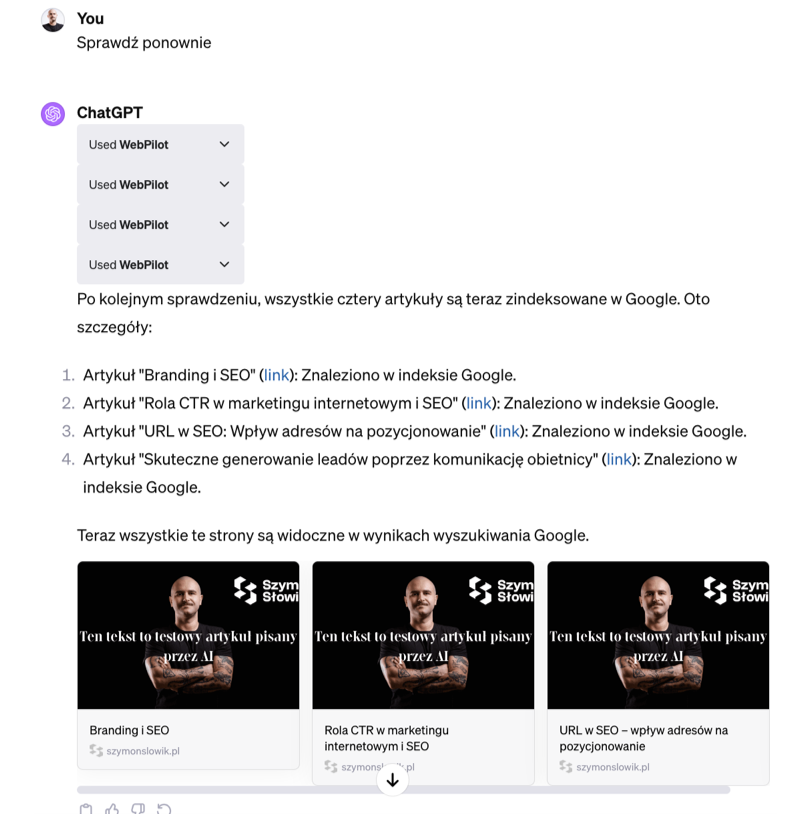

Następnego dnia rano (sprawdziłem o 10:00) ChatGPT z wykorzystaniem pluginu WebPilot poinformował mnie, że wszystkie URL są w indeksie.

Dorzucam jeszcze zrobiony parę godzin później zrzut z Inspektora URL w Google Search Console:

Co więcej pojawiły się pierwsze kliki według Google Analytics:

Wnioski są dość proste i pewnie niezbyt zaskakujące dla SEO-wców, którym AI nie jest obce i nie boją się korzystać z LLM, asystentów pisania, ChatGPT itd.

Dla osób, które w niewielkim stopniu korzystały z tych narzędzi mogą jednak być wartościowe.

Wnioski z eksperymentu:

- Teksty pisane przez AI (różnymi metodami – nawet najprostszymi) mogą być bez problemu indeksowane.

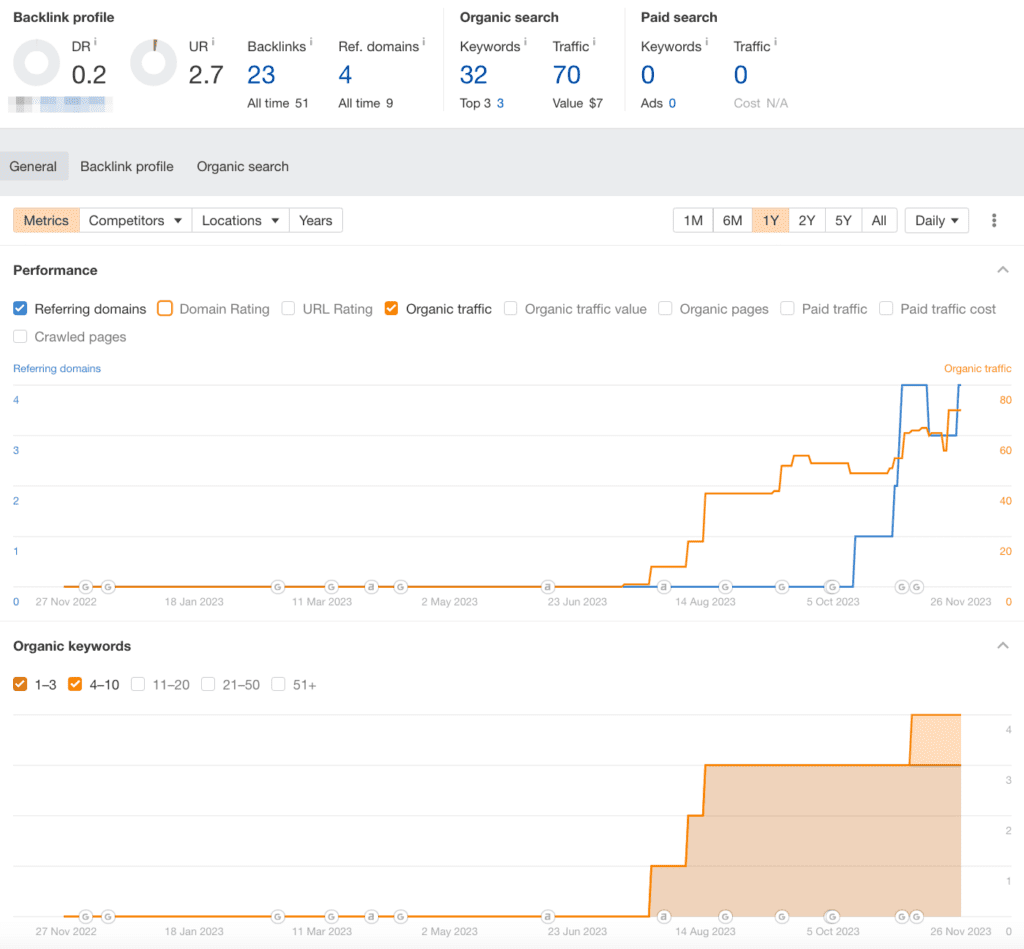

- Jednym z kluczowych czynników wpływających na indeksację jest historia domeny (obstawiam autorytet linkowy i historię publikowanych treści, na podstawie czego Google może dokonywać predykcji, czy warto indeksować kolejne).

- Czas indeksacji artykułu pisanego z wykorzystaniem AI może wynieść nawet kilka godzin.

- Artykuł pisany przez AI już kilka do kilkunastu godzin po publikacji może generować ruch z Google.